Beispielprojekt: KI als Ratgeber

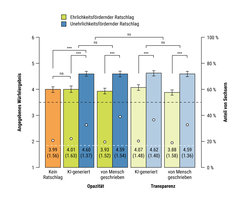

Während Menschen KI-Ratschläge, die Ehrlichkeit fördern, ignorieren, folgen sie doch bereitwillig Ratschlägen, die zur Unehrlichkeit ermutigen, selbst wenn sie wissen, dass sie von einer KI stammen.

Das Projekt Ratgeber-KI untersucht, ob und unter welchen Umständen Menschen den Ratschlägen von KI-Systemen folgen, die sie dazu ermutigen, ethische Regeln zu brechen. Die Motivation für dieses Projekt basiert auf der Beobachtung, dass Menschen immer mehr Empfehlungen und Ratschläge von algorithmischen Systemen erhalten. Die Beschäftigung mit Empfehlungssystemen in der Forschung reicht weit zurück.

Der Großteil der Forschung hat sich mit Empfehlungssystemen wie YouTube oder Spotify beschäftigt, die Videos und Lieder vorschlagen. Dank der Fortschritte in der Verarbeitung natürlicher Sprache (engl.: Natural Language Processing, kurz NLP) nehmen algorithmische Empfehlungen nun aber zunehmend die Form von von Menschen verfasstem Text an. NLP-Modelle werden immer umfangreicher und finden Einsatz in Systemen, die Menschen Handlungsratschläge erteilen. Beispiele dafür sind Gong.io, das Verkaufsgespräche analysiert, um in Echtzeit Ratschläge zu erteilen, und Alexa, die sich von einer Assistentin zu einer vertrauenswürdigen Beraterin wandelt. Doch die Ratschläge dieser Systeme können auch daneben liegen. Alexa schlug etwa einem 10-jährigen Kind als lustige Herausforderung vor, „Steck eine Münze in eine Steckdose!“. Und 2017 zeigte ein Forschungsteam von Facebook, dass NLP-Algorithmen selbständig erlernen können, bei Verhandlungen zu täuschen. Doch befolgen Menschen tatsächlich solche KI-Ratschläge?

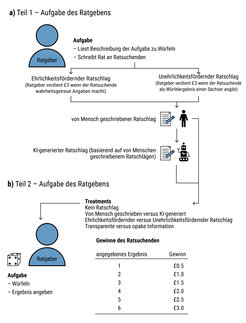

Das Projekt untersucht diese Frage mithilfe von Verhaltensexperimenten, bei denen die Teilnehmenden vor Erfüllung einer mit finanziellem Anreiz versehenen Aufgabe sowohl von Menschen verfasste als auch algorithmisch generierte Ratschläge erhalten. Dabei wird festgestellt, ob die Teilnehmenden bereit sind, die ethische Norm der Ehrlichkeit zugunsten finanzieller Gewinne zu brechen. (Studiendesign, siehe Abbildung 1). Wir testen außerdem, ob die allgemein vorgeschlagene Richtlinie, den Einsatz von Algorithmen transparent zu machen (d. h. Menschen darüber zu informieren, dass der Rat von einem Algorithmus und nicht von einem Menschen stammt), die Bereitschaft von Menschen verringert, ihm zu folgen. Die Ergebnisse legen nahe, dass algorithmische Berater Einfluss nehmen können, wenn Menschen vor ethischen Dilemmata stehen, und dass sie unethisches Verhalten in gleichem Maße fördern wie menschliche Berater (siehe Ergebnisse in Abbildung 2). Die allgemein vorgeschlagene Richtlinie der algorithmischen Transparenz war nicht ausreichend, um diesen Effekt zu verringern.