In der Echokammer

Freiheit in den sozialen Medien ist eine Illusion: Algorithmen geben vor, welche Inhalte die Nutzer und Nutzerinnen lesen

Studien zeigen: Je lauter politische Minderheiten in den sozialen Netzwerken schreien, desto stiller wird die demokratische Mehrheit. Hass, Hetze und Propaganda gedeihen in Echokammern besonders gut, dadurch wird die Wahrnehmung im politischen Diskurs verzerrt. Forschende untersuchen dieses Phänomen sozialwissenschaftlich, juristisch und mathematisch.

Text: Sabine Fischer

Es ist laut am Rednerpult des Deutschen Bundestags. Wenn Beatrix von Storch (Alternative für Deutschland) dort gegen den Green New Deal wettert oder wenn ihr AfD-Kollege René Springer „massenweise Remigration“ fordert, schallen fast sekündlich Gegenrufe durch den Plenarsaal. Laute Argumente aus den Reihen der restlichen Fraktionen, empörte Widerrede, Aufforderungen, nun doch bitte zum Ende zu kommen. In der Kommentarspalte des TikTok-Profils, das die Bundestagsfraktion der AfD betreibt, findet man hingegen kaum Widerworte. Hier, wo regelmäßig Ausschnitte solcher Redebeiträge veröffentlicht werden, scheint die Community sich einig: Endlich sagt es mal jemand.

Dominiert werden diese Beiträge von schrillen Aussagen, die das Social-Media-Team der Partei prominent und gut sichtbar in die Mitte der jeweiligen Videos schreibt: „Wir brauchen die Festung Europa!“, „Die Bürger werden über den Tisch gezogen!“, „Wie verblödet kann man sein?!“ Laute Parolen in schwarzer Schrift auf weißem Hintergrund – eine Aufmachung, die auf den ersten Blick seriös wirkt und gerade deshalb umso gefährlicher ist.

Was in der Community viel Zustimmung auslöst, sind in Wahrheit aufs Äußerste zugespitzte Aussagen ohne Kontext, die sich nicht überprüfen lassen – eine Form von Propaganda, die in den sozialen Medien besonders gut funktioniert: „Die Beiträge der AfD-Bundestagsfraktion sind ein gutes Beispiel dafür, wie solche Inhalte auf sozialen Plattformen funktionieren“, sagt Philipp Lorenz-Spreen, der sich am Max-Planck-Institut für Bildungsforschung unter anderem mit dem selbst organisierten Onlinediskurs und dessen Auswirkungen auf die Demokratie beschäftigt. „TikTok ist auf kurze Inhalte mit Knalleffekten optimiert, die für ein paar Sekunden Aufmerksamkeit auf sich ziehen. Solche provokanten, emotionalisierten Inhalte belohnt das System und spielt sie häufig aus.“

Diese Formel scheint die AfD verstanden zu haben: Mit ihren Formaten erreicht die Bundestagsfraktion auf TikTok regelmäßig Hunderttausende Personen – Zahlen, von denen andere dort vertretene Parteien nur träumen können. Viele von ihnen haben das Potenzial und die Reichweite dieses Netzwerks lange Zeit unterschätzt. Beiträge der Bundestagsfraktionen von CDU oder SPD erreichen auf TikTok durchschnittlich nur niedrige fünfstellige Bereiche. Mit fatalen Folgen: Hatespeech, Populismus und Propaganda wandern so in die Feeds zahlloser Userinnen und User – und das oft, ohne dass sie auf den ersten Blick erkennbar wären.

Keine Freiheit in den sozialen Medien

Wie beeinflussen Algorithmen unsere Meinungsbildung? Können wir uns in den sozialen Medien überhaupt frei bewegen oder entscheiden? Lorenz-Spreen ist sehr skeptisch. Die Vorstellung, dass Menschen sich auf sozialen Plattformen frei bewegen könnten, sei eine Illusion: „Alles, was man im Feed zu sehen bekommt oder worauf unsere Aufmerksamkeit gelenkt wird, ist von der jeweiligen Plattform vorgegeben und konstruiert. Einen neutralen Raum kann es daher nicht geben.“ Dass Nutzerinnen und Nutzer mit dem Aufrufen ihres Profils auf Instagram, Facebook oder TikTok in einen Raum treten, der die eigene Entscheidungsfreiheit einschränkt, bleibt für sie zunächst unsichtbar. „Es mangelt massiv an Transparenz“, erklärt Lorenz-Spreen. „Als Nutzerinnen und Nutzer sehen wir lediglich eine angenehme, glatte Benutzeroberfläche. Wir haben keine Informationen darüber, wie und woher die Inhalte kommen, die uns angezeigt werden, oder warum uns andere Inhalte nicht angezeigt werden.“ Informationen darüber, warum Inhalte im Feed angezeigt werden und welche Quellen sie eigentlich haben, sind meistens schlicht nicht verfügbar. Auch aufmerksame Personen können sich aus dieser Falle kaum befreien.

Mehr Transparenz zu schaffen, sei jedoch auch für die Plattformen selbst schwierig, findet Lorenz-Spreen. „Wenn wir als Nutzende zum Beispiel die ganze Zeit angezeigt bekämen, wie der Algorithmus im Hintergrund funktioniert, würde uns das überfordern und die Nutzung stören.“ Eine Lösung sieht er eher in spielerischen Ansätzen: „Plattformen könnten Nutzerinnen und Nutzer den Algorithmus spielerisch verändern lassen. Wenn man zum Beispiel einstellen könnte, dass man mehr politische Inhalte angezeigt bekommen möchte, würde man gleichzeitig ein Bewusstsein dafür entwickeln, dass Inhalte vorab selektiert werden.“

Aufmerksamkeit bringt Profit

Doch kommerzielle Plattformen verfolgen eigene Ziele: Um wirtschaftlich erfolgreich zu sein, müssen sie ihre Nutzerinnen und Nutzer möglichst lange halten. Aufmerksamkeit wird zur Währung. Damit diese in möglichst hohen Raten bezahlt wird, nutzen soziale Medien die menschlichen Bedürfnisse nach Unterhaltung und Bestätigung. Wer verbringt schließlich nicht gern Zeit an einem Ort, an dem er sich wohlfühlt und gut unterhalten wird?

Doch das führt dazu, dass sich auf diesen Plattformen soziale Echokammern bilden. „Menschen sind soziale Wesen und umgeben sich gern mit anderen, die ähnliche Ansichten teilen. Wir sind homophil und streben nach einem kohärenten Weltbild. Daher entstehen oft Gruppen von Menschen, die ähnliche Ansichten haben“, so Lorenz-Spreen. Soziale Netzwerke wirkten hierbei wie ein Katalysator, erklärt er weiter. „Auf diese Weise befriedigen Plattformen ihr kommerzielles Bedürfnis, Nutzerinnen und Nutzer so lange wie möglich zu binden, und fördern gleichzeitig die Bildung sozialer Echokammern.“

Doch in Räumen, in denen das eigene Weltbild von allen Seiten bestätigt wird, sind Menschen anfälliger für Phänomene wie Propaganda, Hatespeech und Falschinformationen: „Eine Erklärung dafür ist der false consensus, also das Gefühl, dass einem plötzlich Tausende von Menschen zustimmen, und man glaubt, das sei die Mehrheit“, so Lorenz-Spreen. Dazu kommt außerdem ein demokratisches Problem: „Soziale Echokammern eignen sich nicht für die Debattenkultur“, sagt Lorenz-Spreen.

Sichtbare Öffentlichkeit im Netz

Diese Erkenntnis lässt sich sogar messen: Am Max-Planck-Institut für Mathematik in den Naturwissenschaften in Leipzig erforscht Eckehard Olbrich den Einfluss sozialer Medien auf die Demokratie und die Visualisierung der digitalen Öffentlichkeit. Er entwickelte in dem Projekt „Odycceus“ Instrumente, um die Ausprägung von Echokammern in sozialen Netzwerken zu messen. „Eine empirische Einsicht war, dass die Echokammern nicht geschlossen sind. Es kann also Austausch zwischen den einzelnen Lagern stattfinden – wenngleich dieser durchaus feindselig sein kann“, sagt er. Olbrich und sein Team untersuchten anhand von Clustern beispielsweise die Interaktion zwischen politisch linken und politisch rechten Netzwerken auf X (ehemals Twitter) in einer Fallstudie in Sachsen. „Wir fanden heraus, dass rechte Accounts auf linke Inhalte aktiver reagieren als umgekehrt.“

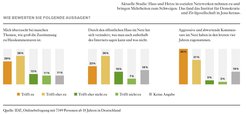

Welche Folgen haben Echokammern für den Einzelnen – und die Gesellschaft? Rund ein Viertel aller Internet-Nutzerinnen und -Nutzer ist laut dem Statistischen Bundesamt im vergangenen Jahr mit Hatespeech in Kontakt gekommen. Eine Untersuchung des Instituts für Demokratie und Zivilgesellschaft hat ermittelt, was Hass und Hetze mit Betroffenen und dem öffentlichen Dialog machen. Das Ergebnis: Rund zwei Drittel der Personen, die selbst schon einmal davon betroffen waren, berichten von negativen Auswirkungen wie emotionalem Stress, Angst, Unruhe oder Depressionen. Personen, die im Internet mit Hatespeech in Berührung kommen, werden zudem eingeschüchtert und teilweise aus dem öffentlichen Dialog verdrängt. Rund die Hälfte der Befragten gaben in einer 2024 veröffentlichten Studie des „Kompetenzzentrums gegen Hass im Netz“ an, sich als Reaktion auf Hassrede seltener an Diskussionen im Internet zu beteiligen und ihre politische Meinung eher zu verheimlichen.

Schaden und Nutzen für die Demokratie

Die Auswirkungen auf die Gesellschaft sind gravierend. Philipp Lorenz-Spreen untersuchte zusammen mit Lisa Oswald, Stephan Lewandowsky und Ralph Hertwig, wie die Social-Media-Nutzung die Demokratie beeinflusst. Das Forschungsteam analysierte rund 500 wissenschaftliche Artikel, die korrelative und kausale Zusammenhänge zwischen der Nutzung sozialer Medien und politischem Verhalten aufzeigen. Ihr Ergebnis: Soziale Medien haben positive und negative Effekte auf die Demokratie. Sie erhöhen zwar die politische Partizipation und motivieren mehr Menschen zu Protestaktionen oder bürgerschaftlichem Engagement, zudem ermöglichen sie es auch besser als andere Medien, Menschen ihrem Bildungsgrad entsprechend zu informieren. Aber es gibt auch Nachteile. „Wir sehen viele Zusammenhänge zwischen dem Vertrauen in demokratische Institutionen und der Nutzung sozialer Medien. Das Vertrauen sinkt, je stärker Menschen soziale Medien nutzen.“ Die genaue Ursache sei Gegenstand weiterer Forschung, klar sei allerdings, dass Vertrauen in Institutionen ein Grundpfeiler einer funktionierenden Demokratie ist.

Die Studie zeigt auch, dass soziale Medien Propaganda und Populismus begünstigen: „Populistische Parteien sind auf sozialen Plattformen besonders erfolgreich, was sich auf die Offline-Welt überträgt. Dies steht im Zusammenhang mit dem Vertrauen in staatliche Institutionen selbst. Je schwächer dieses Vertrauen ist, desto leichter hat es der Populismus mit den Feindbildern.“ In sozialen Medien funktioniere dies besonders gut durch verkürzte Inhalte und das Gruppengefühl in den sozialen Echokammern. Alles in allem sieht Lorenz-Spreen Grund zur Sorge: „Wenn wir uns diese Ergebnisse vor Augen führen, zumal in dem Wissen, dass Demokratien weltweit gerade in einer Krise stecken, sehe ich eine große Frage: Wie gehen wir damit um?“ Wie lässt sich das Biest der kommerziellen sozialen Plattformen zähmen? Lassen sich negative Effekte wie etwa Propaganda, Falschinformationen und Hatespeech eindämmen?

Gesetzgebung hinkt technologischer Entwicklung hinterher

So richtig erfolgreich waren diese Bemühungen bisher allerdings nicht, findet Johanna Rinceanu, Senior Researcher am Max-Planck-Institut zur Erforschung von Kriminalität, Sicherheit und Recht: „Wir beobachten online eine Verrohung der Debattenkultur, die bisher noch nicht eingedämmt werden konnte“, sagt die promovierte Juristin. Es hakt an vielen Stellen. So erschwert etwa die Geschwindigkeit der technischen Entwicklung die gesetzliche Regulierung. „Das Internet entwickelt sich in Lichtgeschwindigkeit, während die Gesetzgebung auf dem Pferd unterwegs ist und mit diesem Tempo nicht mithalten kann“, so Rinceanu. Außerdem steht der Versuch einer Regulierung immer im Spannungsfeld zwischen Meinungsfreiheit und dem Schutz vor Hass und Hetze. Eine Auslegung ist schwierig. Da Hatespeech zum Beispiel keine juristische Definition hat, muss in jedem einzelnen Fall neu entschieden werden, ob Äußerungen als Volksverhetzung gelten und damit strafrechtlich relevant sind oder unter die Meinungsfreiheit fallen.

Einen gesetzlichen Rahmen für dieses Dilemma zu finden, ist schwierig. Der neueste Versuch: Der Digital Services Act legt seit Februar fest, wie Onlineplattformen innerhalb der Europäischen Union mit Hatespeech, Fake News und Co. umzugehen haben. Welche Beiträge tatsächlich strafbar sein könnten, wird dabei durch das sogenannte „Notice and action“-Modell ermittelt: Nutzerinnen und Nutzer können den Plattformen potenziell strafbare Inhalte mitteilen, die diese dann überprüfen und gegebenenfalls löschen müssen. Außerdem sind die Plattformen verpflichtet, bestimmte strafrechtlich relevante Inhalte an die zuständigen Behörden zu melden.

Bis zum Inkrafttreten des Digital Services Act geschah das in Deutschland aufgrund des sogenannten Netzwerkdurchsetzungsgesetzes. Europaweit galt es als Blaupause und Grundlage für die neue EU-Norm. Für die Rechtswissenschaftlerin Rinceanu war dieser Vorstoß jedoch ein Fehlversuch, Hass und Hetze im Netz beizukommen. Zwar sei die Intention, ein politisches Zeichen gegen Propaganda und Hass im Netz zu setzen, richtig gewesen. Doch das Gesetz sei zu schnell und zu undurchdacht verabschiedet worden. Zum Beispiel verpflichtete es private Unternehmen wie soziale Plattformen dazu, binnen kurzer Fristen (zwischen 24 Stunden und sieben Tagen) darüber zu entscheiden, ob ein Inhalt strafrechtlich relevant sei oder nicht.

Gesetz fördert übermäßige Löschungen

„Das ist nicht die Aufgabe von Privatpersonen, sondern der Justiz“, kritisiert Rinceanu. Weil die Frist für das Löschen rechtswidriger Beiträge zudem kurz und die Menge an Inhalten groß sei, hätten die Plattformen kaum Zeit, einzelne Inhalte angemessen zu prüfen. „Zwar kann diese Aufgabe durch künstliche Intelligenz und Algorithmen unterstützt werden, aber viele Feinheiten können von den Systemen noch nicht wahrgenommen werden: Poste ich einen Artikel zum Beispiel, um mich kritisch dazu zu äußern oder weil ich seinen Inhalt verbreiten will? Am Ende braucht es immer eine Bewertung durch den Menschen.“ Doch dieser Aufgabe seien Mitarbeitende privater Unternehmen gar nicht gewachsen. Die Folge: „Die Sorge, das Netzwerkdurchsetzungsgesetz führe dazu, dass übermäßig viele Inhalte gelöscht und gemeldet werden, war mit Blick auf die Entwicklung in den letzten fünf Jahren absolut berechtigt“, so Rinceanu. Sie verweist auf Staaten, die die Regelung übernommen haben. „Darunter waren auch viele sogenannte defekte Demokratien oder autokratische Systeme wie Kenia oder Belarus. Um Wahlen zu manipulieren, wurde hier dann mithilfe der Regelungen durchgesetzt, dass beispielsweise Inhalte gelöscht werden mussten.“

Der Digital Services Act, der große wie kleine Onlineanbieter in die Verantwortung nimmt, gibt Rinceanu Hoffnung. Sie begrüßt, dass die Verordnung keine konkrete Zeitspanne mehr für das Löschen der Beiträge vorgibt. So erhielten Plattformen mehr Zeit, um Inhalte angemessen zu prüfen. Zudem müssen nur noch solche Inhalte an die Behörden gemeldet werden, in denen es eine Bedrohung für das eigene Leben oder die persönliche Sicherheit gibt, zum Beispiel Morddrohungen. „Man muss jetzt sehen, ob der Digital Services Act nur eine Beautyfication ist oder ob er tatsächlich dazu beiträgt, dass soziale Plattformen effektiv reguliert werden“, sagt sie.

Verfahren gegen TikTok

Ein prominenter Anwendungsfall ist das Verfahren der EU-Kommission gegen TikTok wegen Defiziten beim Jugendschutz, fehlender Transparenz bei Werbung und mangelnden Datenzugangs für Forschende. Auch TikToks Risikomanagement in Bezug auf süchtig machendes Design und schädliche Inhalte steht auf dem Prüfstand. „Der Schutz von Kindern und Jugendlichen hat bei der Regulierung sozialer Plattformen oberste Priorität. Es überrascht nicht, dass die EU nun prüft, welche Risikobewertungen und Maßnahmen TikTok als sehr große Onlineplattform mit über 135 Millionen monatlichen Nutzern in der EU unternimmt, um dem Risiko von Verhaltensabhängigkeiten oder Radikalisierungsprozessen vorzubeugen“, sagt Rinceanu. Ein Verstoß gegen den Digital Services Act kann teuer werden: Bis zu sechs Prozent des weltweiten Vorjahresumsatzes muss TikTok als Geldbuße bezahlen, falls die EU-Kommission einen Verstoß feststellt. Wann das Verfahren abgeschlossen wird, ist noch offen.

Ob eine EU-Verordnung reicht, um Hass und Hetze in den Griff zu bekommen, wird sich zeigen. Um langfristig etwas zu ändern, müsse der Versuch einer Regulierung weitaus früher ansetzen, findet Rinceanu: „Hatespeech und Co. sind Symptome einer gesellschaftlichen Erkrankung, und wir müssen die zugrunde liegenden Strukturen und Dynamiken erst einmal aufdecken, um besser zwischen Symptomen und Ursachen unterscheiden zu können. Nur so kann man eine sinnvolle Diagnose stellen und die beste Therapie finden.“

Der Artikel stammt aus dem Magazin Max Planck Forschung 1/2024.

Auf den Punkt gebracht

Freiheit in den sozialen Medien ist eine Illusion: Algorithmen kommerzieller Plattformen schaffen einen künstlichen Raum. Der gibt vor, welche Inhalte in den jeweiligen Feeds der Nutzenden landen – meist unbemerkt.

Durch die Bildung sozialer Echokammern und das Belohnungssystem der Algorithmen sind Menschen in den sozialen Medien besonders anfällig für Propaganda, Hatespeech und Falschinformationen.

Die Nutzung sozialer Medien hat nachweislich negative Effekte auf das Vertrauen in demokratische Institutionen und fördert Propaganda.